北大美女学霸力压大神何恺明新作MAE!怒摘12个SOTA,灵感竟来自16年前CVPR论文

新智元报道

编辑:小咸鱼好困

【新智元导读】近日,北大校友、约翰·霍普金斯大学博士生提出了一种新的方法:MaskFeat,力压大神何恺明的新作 MAE,摘下 12 个 SOTA!

什么叫卷?

CV 大神何恺明的力作「Masked Autoencoders Are Scalable Vision Learners」(MAE) 刚出了一个多月。

又有新 SOTA 出来了!

这是一个能用于视频模型的自监督预训练方法:掩码特征预测(MaskFeat)。

https://arxiv.org/abs/2112.09133

简而言之,MaskFeat 的 ViT-B 在 ImageNet 1K 上的准确率达到了 84.0%,MViT-L 在 Kinetics-400 上的准确率达到了 86.7%,成功地超越了 MAE,BEiT 和 SimMIM 等方法。

一作 Chen Wei 是约翰·霍普金斯大学的计算机科学博士生,此前在北京大学获得了计算机科学学士学位。

并曾在 FAIR、谷歌和华为诺亚方舟实验室实习,主要研究方向是视觉自我监督学习。

MAE 刚提出就 OUT 了?

MAE 最大的贡献,可能就是将 NLP 领域和 CV 两大领域之间架起了一座更简便的桥梁。

https://arxiv.org/abs/2111.06377

此前,大名鼎鼎的 GPT 和 BERT 已经将大型自然语言处理(NLP)模型的性能提升到了一个新的高度。

直观点讲,就是事先遮住一些文本片段,让 AI 模型通过自监督学习,通过海量语料库的预训练,逐步掌握上下文语境,把这些被遮住的片段,用尽可能合乎逻辑的方式填回去。

这和我们做「完形填空」的方式有些类似。经过海量数据的学习和训练,AI 模型慢慢学会了自己生成自然文本。目前,随着 GPT 及其后续改进模型的不断进步,生成的自然文本几乎可以乱真。

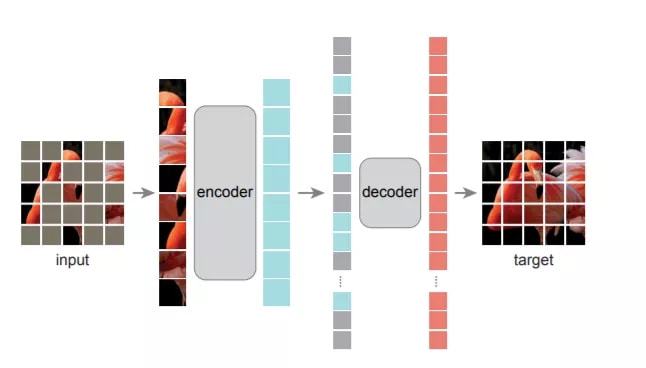

而何恺明的 MAE 就是把 NLP 领域已被证明极其有效的方式:「Mask-and-Predict」,用在了计算机视觉(CV)领域,先将输入图像的随机部分予以屏蔽(Mask),再预测(Predict)丢失的像素(pixel)。

MAE 模型简单,效果却很拔群。

而就在上周,Facebook AI Research 和约翰霍普金斯大学的研究人员提出了 MaskFeat,也是采用「Mask-and-Predict」的方法,性能却比 MAE 上更进一步。

那 MAE 输在了哪里呢?

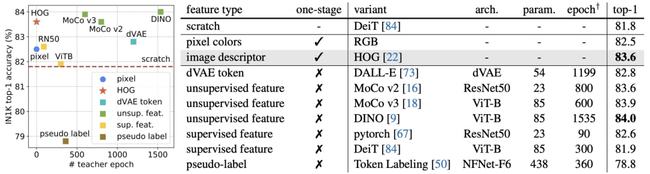

HOG VS Pixel Colors

「Mask-and-Predict」总要有个可以「Predict」的特征来让模型学习到东西。

MaskFeat 最核心的改变就是将 MAE 对图像像素(pixel)的直接预测,替换成对图像的方向梯度直方图(HOG)的预测。

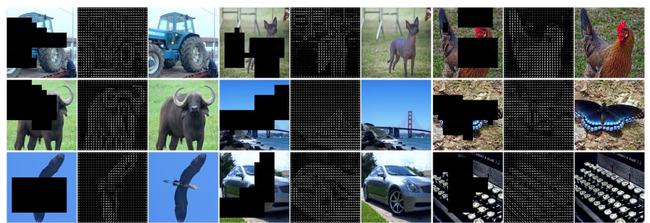

图像 HOG 特征向量

说到 HOG,这可不是什么新鲜玩意儿。

HOG 是一种经典的图像特征提取算法,发表于 2005 年的 CVPR,到现在已经收获了 37000+ 的引用。

https://hal.inria.fr/file/index/docid/548512/filename/hog_cvpr2005.pdf

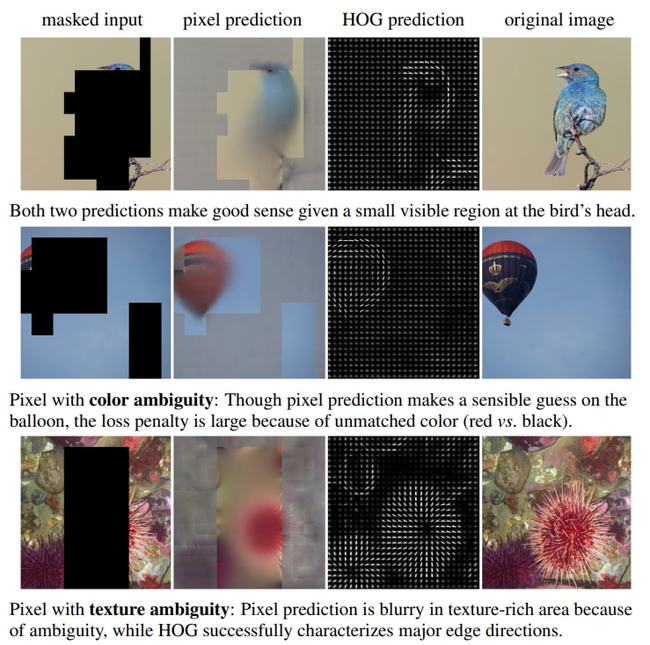

那为什么预测图像的 HOG 比直接预测像素更好呢?

像素作为预测目标,有一个潜在的缺点,那就是会让模型过度拟合局部统计数据(例如光照和对比度变化)和高频细节,而这些对于视觉内容的解释来说很可能并不是特别重要。

相反,方向梯度直方图(HOG)是描述局部子区域内梯度方向或边缘方向分布的特征描述符,通过简单的梯度滤波(即减去相邻像素)来计算每个像素的梯度大小和方向来实现的。

通过将局部梯度组织化和归一化,HOG 对模糊问题更加稳健

HOG 的特点是善于捕捉局部形状和外观,同时对几何变化不敏感,对光的变化也有不变性,计算引入的开销还很小,可以忽略不计。

这次,MaskFeat 引入 HOG,其实正是将手工特征与深度学习模型结合起来的一次尝试。

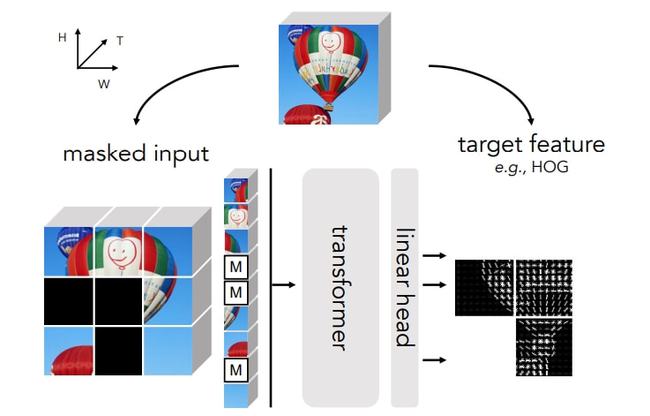

MaskFeat 首先随机地 mask 输入序列的一部分,然后预测被 mask 区域的特征。

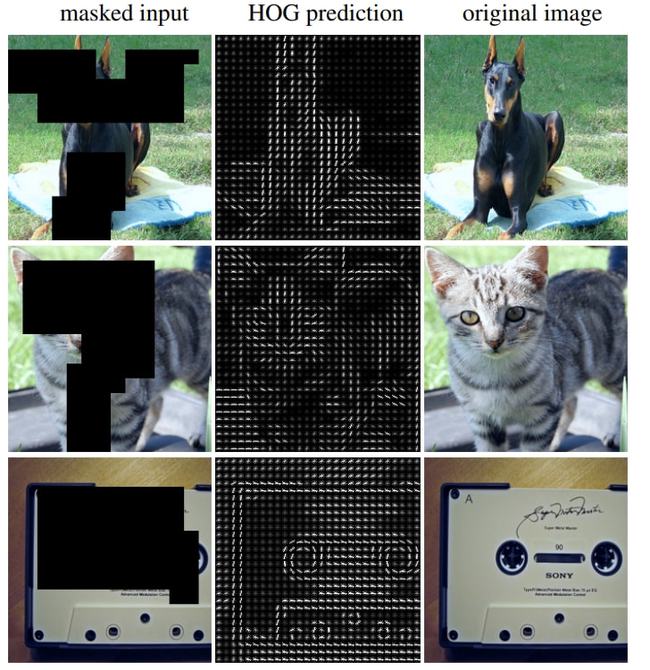

对未见过的验证图像的 HOG 预测

只不过,模型是通过预测给定 masked input(左)的 HOG 特征(中间)来学习的,原始图像(右)并不用于预测。

方向梯度直方图(HOG)这个点子的加入使得 MaskFeat 模型更加简化,在性能和效率方面都有非常出色的表现。

在不使用额外的模型权重、监督和数据的情况下,MaskFeat 预训练的 MViT-L 在 Kinetics-400 数据集上获得了 86.7% 的 Top-1 准确率。

这个成绩以 5.2% 的幅度领先此前的 SOTA,也超过了使用如 IN-21K 和 JFT-300M 这些大规模图像数据集的方法。

此外,MaskFeat 的准确率在 Kinetics-600 数据集上为 88.3%,在 Kinetics-700 数据集上为 80.4%,在 AVA 数据集上为 38.8 mAP,而在 SSv2 数据集上为 75.0%。

结果分析

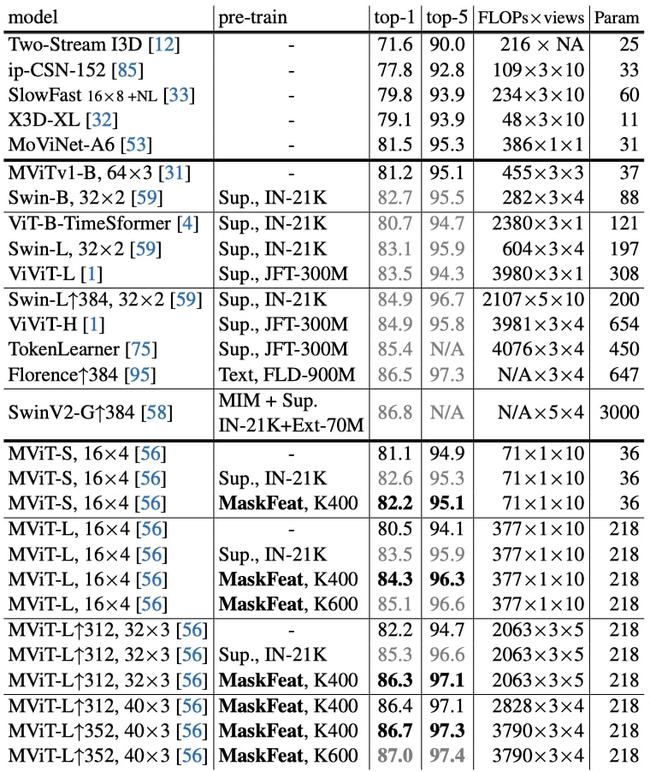

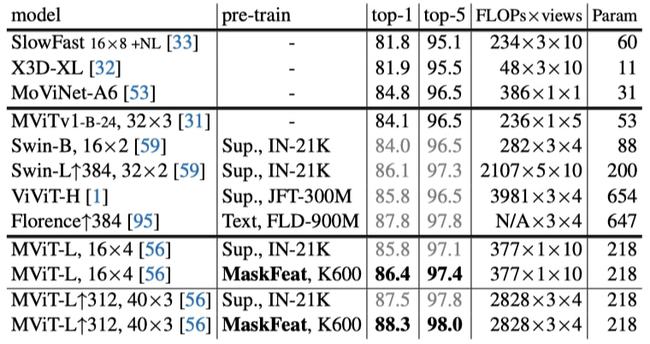

Kinetics-400 数据集

相比于不使用预训练的 CNN,严重依赖大规模图像数据集和监督性预训练的基于 Transformer 的方法,MaskFeat 表现出极佳的性能。

在 Kinetics-400 数据集上的比较

经过 300 个 epoch 预训练的 MaskFeat 将 MViT-S,16×4 的 81.1% 的 top-1 准确率提高了 1.1%。其中,16×4 表示该模型在训练过程中采用 16 个时间跨度为 4 的帧作为输入。

而在 K400 上用 MaskFeat 预训练了 800 个 epoch 的 MViT-L 16×4 达到了 84.3% 的 top-1 准确率,比其基线高出了 3.8%,比使用 IN-21K 训练的监督模型高出了 0.8%。

MaskFeat 也以一己之力将 K400 上没有外部数据的最佳准确率(MoViNet-A6 的 81.5%)提高了 5.2%。

此外,MaskFeat 仅用 K400 的结果(86.7%)就能和 86.5% 的 Florence 和 86.8% 的 SwinV2-G 不相上下。其中,Florence 使用了 9 亿个文本-图像对,SwinV2-G 使用了一个具有 30 亿个参数的巨型模型,并首先在 IN-21K 和 7 千万张内部图像的大型数据集上进行自我监督和监督预训练。

可以说,MaskFeat 在参数量、计算成本、数据和注释方面的高效性再次证明了直接在未标记的视频上进行预训练的优势,也为一种全新的视频预训练方式打开了大门。

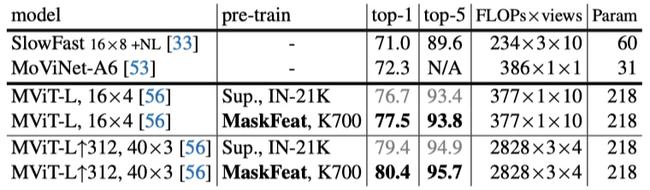

Kinetics-600 & Kinetics-700 数据集

在 Kinetics-600 数据集上的比较

在 Kinetics-700 数据集上的比较

MaskFeat 在 K600 和 K700 上分别达到了 86.4% 和 77.5% 的 top-1 准确率,与之前基于 Transformer 的方法相比,既没有使用外部的图像数据,而且 FLOPs 还减少了 10 倍以上。

而在更大的输入分辨率 312 和更长的持续时间 40×3 下,MaskFeat 在 K600 上实现了 88.3% 的 top-1 准确率,在 K700 上实现了 80.4% 的 top-1 准确率。

于是,MaskFeat 在没有任何外部监督(如 IN-21K 和 JFT-300M)的情况下,为每个数据集都创造了新的 SOTA。

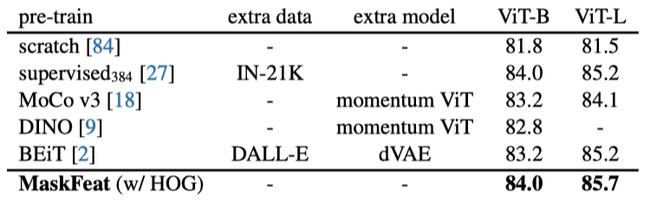

ImageNet-1K 数据集

对 MaskFeat 进行 1600 个 epoch 的预训练,在 ViT-B 上微调 100 个 epoch,在 ViT-L 上微调 50 个 epoch。

当图像大小为 224x224 时,MaskFeat 与在 IN-21K 上进行的有监督的预训练相比,在 ViT-B 上打成了平手,而在 ViT-L 上直接实现了超越。

当图像大小为 384x384 时,利用 IN-21K 的有监督预训练需要用到比 MaskFeat 多 10 倍的图像和标注。

通常来说,由于缺乏典型的 CNN 归纳偏置,ViT 模型对数据要求很高,并且需要大规模的监督预训练。而 MaskFeat 可以在没有外部标记数据的情况下通过解决特征图像修复任务来克服这个问题。

此外,与 BEiT 相比,MaskFeat 只需要计算 HOG 特征,摆脱了 dVAE 的 tokenizer。而后者在 250M DALL-E 数据集上引入了额外的预训练阶段,并在 mask 预测期间引入了不可忽视的推理开销。与 MoCo v3 和 DINO 相比,MaskFeat 也更准确、更简单。

此处 MaskFeat 的预训练为 300 个 epoch

随着 MAE、MaskFeat 等模型的出现,NLP 界的制胜武器「Mask-and-Predict」会是 CV 自监督预训练的下一个标准范式吗?

对此,来自清华大学的知友「谢凌曦」表示:

视觉自监督领域做了这么些年,从最早的生成式学习出发,绕了一圈,又回到生成式学习。 到头来,我们发现像素级特征跟各种手工特征、tokenizer、甚至离线预训练网络得到的特征,在作为判断生成图像质量方面,没有本质区别。 也就是说,自监督也许只是把模型和参数调得更适合下游任务,但在「新知识从哪里来」这个问题上,并没有任何实质进展。

参考资料:

https://arxiv.org/pdf/2112.09133.pdf

https://www.zhihu.com/question/506657286/answer/2275700206

或许,答案并不遥远了。

来自: www.163.com