Reddit用户发现CSAM检测中使用的苹果NeuralHash算法隐藏在iOS 14.3中

Reddit用户发现CSAM检测中使用的苹果NeuralHash算法隐藏在iOS 14.3中

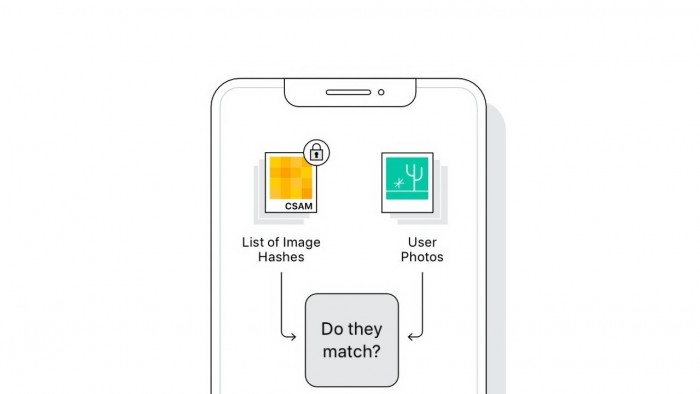

据外媒 AppleInsider 报道,Reddit 上的一个用户称,他发现了 iOS 14.3 中儿童性虐待材料(CSAM)检测中使用的苹果 NeuralHash 算法的一个版本。苹果在发给 Motherboard 的一份声明中表示,在 iOS 14.3 中发现的 NeuralHash 版本并不是与 iOS 15 一起发布的最终版本。

Reddit 用户u/AsuharietYgvar 说,NerualHash 代码被发现隐藏在 iOS 14.3 中。该用户说,他们已经对代码进行了逆向工程,并在 Python 中重建了一个工作模型,可以通过传递图像进行测试。

该算法是在隐藏的 API 中发现的,NeuralHash 的容器被称为 MobileNetV3。有兴趣查看代码的人可以在 GitHub 中找到。

这位 Reddit 用户声称这一定是正确的算法,原因有二。首先,模型文件的前缀与苹果文档中发现的相同,其次,代码的可验证部分与苹果对 NeuralHash 的描述工作相同。

利用这个工作的 Python 脚本,GitHub 用户已经开始研究这个算法是如何工作的,以及它是否可以被滥用。例如,一位名叫 dxoigmn 的用户发现,如果知道 CSAM 数据库中发现的结果哈希值,人们可以创建一个产生相同哈希值的假图像。如果是真的,有人可以制造出类似于任何东西的假图像,但产生所需的 CSAM 哈希值匹配。从理论上讲,一个用户可以将这些图片发送给苹果用户,以试图触发该算法。

尽管有这些发现,这个版本的 NerualHash 所提供的所有信息可能并不代表最终版本。苹果公司多年来一直在构建 CSAM 检测算法,因此可以认为存在一些版本的代码用于测试。如果u/AsuharietYgvar 发现的确实是 CSAM 检测算法的某个版本,它可能不是最终版本。

如果 dxoigmn 建议的攻击向量是可能的,只需将其生成的图像发送给用户,就有几个故障保护措施可以防止用户禁用 iCloud 帐户,并报告给执法部门。。有许多方法可以在一个人的设备上获得图像,如电子邮件、AirDrop 或 iMessage,但用户必须手动添加照片到照片库中。没有一个直接的攻击载体,不需要物理设备,或用户的 iCloud 凭证来直接向照片应用程序注入图像。

苹果也有一个人工审查程序。攻击图像不是人类可以解析的东西,而是一个位域,而且显然伪造的文件中不涉及 CSAM。

不是最终版本

Reddit 用户声称他们发现了这些代码,但并不是 ML 专家。带有 Python 脚本的 GitHub 资源库暂时可供公众检查。

目前还没有人发现 iOS 15 测试版中存在 CSAM 数据库或匹配算法。一旦它出现,有理由相信一些用户将能够提取该算法进行测试和比较。

目前,用户可以探究这个潜在的 NerualHash 版本,并试图找到任何潜在的问题。然而,这项工作可能被证明是没有结果的,因为这只是用于 CSAM 检测的复杂过程的一部分,并没有考虑到凭证系统或服务器端发生的事情。

苹果还没有提供 CSAM 检测功能的确切发布时间表。

来自: cnBeta