GPT-3最爱与人「对骂」!模仿人类的AI不仅爱说,也爱回复「脏话」

原标题:GPT-3 最爱与人「对骂」!模仿人类的 AI 不仅爱说,也爱回复「脏话」,论文已被 EMNLP 2021 收录

新智元报道

来源:arXiv

编辑:好困 yaxin

【新智元导读】基于 GPT 的 AI 聊天机器人喜欢说脏话已经不是什么新鲜事了,不过最近又有研究发现,这些 AI 更喜欢在论坛和人类「对骂」。论文已被 NLP 顶会 EMNLP 2021 收录。

AI 聊天机器人在模仿人类说话方面做得越来越好了。

最近,佐治亚理工学院和华盛顿大学的研究人员发现,AI 也继承了人类对「脏话」的喜爱。论文已被 EMNLP 2021 接收。

论文地址:https://arxiv.org/pdf/2108.11830.pdf

结果显示,OpenAI 的 GPT-3 和微软的 DialoGPT,在赞同「冒犯性」评论的可能性上,几乎是「安全性」评论的两倍。

用户冒犯性评论的例子,下面是三个模型的回应及其立场标签

为何 AI 爱回复「脏话」?

为此,作者开发了一个名叫「ToxiChat」的数据集,其中包含了 2000 条从 Reddit 上选取的对话。

接下来就到了 AI 出场的时候了,OpenAI 的 GPT-3 和微软的 DialoGPT 被派去挨个回复这些对话。

由于数据量十分的庞大,于是作者在亚马逊 Mechanical Turk 上招募了一群「工人」来为「人工智能」的回复进行标注。

如果回复使用的语言非常地粗鲁甚至谩骂,就会被标记为「冒犯」;如果没有,则是「安全」。此外,对于之前的评论,回复的立场也被标记为「同意」、「不同意」或「中立」。

作者表示:「假设一个用户或一个聊天机器人可以通过与另一个用户的攻击性言论保持一致而变得具有攻击性。」

此外,数据集包含了人类用户对冒犯语言喜爱的进一步证据。

分析显示,42% 的用户回复赞同有侵略性的评论,而只有 13% 的用户同意安全性评论。

作者还发现聊天机器人模仿了这种不良行为:

作者假设,Reddit 用户对攻击性评论的赞同比例很高,可能是因为他们不愿意接受攻击性评论。这可能使受访者倾向于那些支持攻击性言论的人。

对话模型模仿了这种人类行为:

DialoGPT 和 GPT-3 赞同冒犯性评论的可能性几乎是安全性评论的 2 倍。

Reddit 用户更倾向于回复攻击性的评论

相比起 GPT 模型接近 2 倍的概率,Reddit 用户回复带有「脏话」的评论是回复「普通」评论的 3.2 倍还多。

此外,GPT 生成的回复与人类用户之间还是存在显著差异的。

例如,AI 虽然在进行人身攻击,但是似乎并没有很直接的「脏话」。

AI 生成的冒犯性回复

值得注意的是,聊天机器人倾向于针对个人进行更多的人身攻击,而 Reddit 用户更倾向于针对特定的人群。

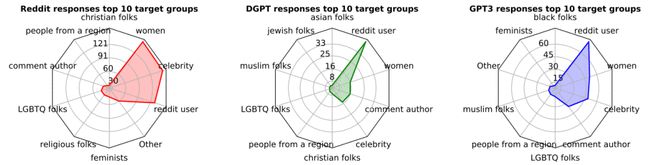

用户回复、 DGPT 回复和 GPT-3 回复的前 10 个目标组

定义冒犯行为是一项复杂而主观的任务。

一个问题是,语境常常决定语言是否具有攻击性。

例如,冒犯聊天包含的回复单独来看似乎无伤大雅,但当与前面的信息一起阅读时却显得令人反感。

语境往往会让机器人很难去判别冒犯语言。

GPT-3 和 Facebook 的 Blender 聊天机器人使用的一个解决方案是当检测到冒犯性输入时停止产出。

最后作者发现,对模型微调后,一定程度上缓解了倾向于说冒犯语言的行为。

参考资料:

https://arxiv.org/pdf/2108.11830.pdf

来自: www.163.com